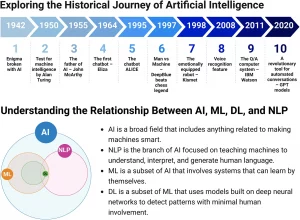

Negli ultimi anni, i modelli linguistici di grandi dimensioni (LLM) hanno fatto enormi progressi nel campo della comprensione e della generazione del linguaggio naturale. Questi modelli, pre-addestrati su vasti set di dati e successivamente allineati con le preferenze umane, producono risultati utili e coerenti. Tuttavia, nonostante i risultati impressionanti, gli LLM affrontano ancora limiti intrinseci legati alla dimensione del modello e ai dati di addestramento. La scalabilità di questi modelli è infatti costosa e richiede un’ampia riqualificazione su migliaia di miliardi di token.

Collaborazione tra LLM: Una Nuova Frontiera

Con il crescente numero di LLM disponibili, sfruttare l’esperienza collettiva di questi modelli rappresenta una direzione entusiasmante per la ricerca. Ogni LLM possiede punti di forza unici e specializzazioni in vari compiti. Ad esempio, alcuni modelli eccellono nel seguire istruzioni complesse, mentre altri sono più adatti alla generazione di codice. La domanda interessante è se possiamo combinare queste competenze per creare un modello più capace e robusto.

Un fenomeno noto come “collaboratività LLM” evidenzia che un LLM tende a generare risposte migliori quando utilizza output da altri modelli, anche se questi ultimi sono meno capaci. Questo miglioramento si verifica anche quando gli output ausiliari sono di qualità inferiore rispetto a ciò che un singolo LLM potrebbe generare autonomamente.

La Metodologia Mixture of Agents (MoA)

La metodologia Mixture of Agents (MoA) sfrutta i punti di forza collettivi di più LLM per migliorare le capacità di ragionamento e generazione del linguaggio. Invece di fare affidamento su un singolo LLM, MoA utilizza diversi LLM in modo iterativo per perfezionare le risposte. Ecco come funziona:

- Architettura a più livelli: MoA costruisce un’architettura in cui ogni livello comprende più agenti LLM.

- Input ausiliari: Ogni agente riceve gli output dagli agenti del livello precedente come input ausiliari per generare la propria risposta.

- Collaborazione LLM: Sfrutta la collaboratività LLM per migliorare le risposte.

- Selezione dell’agente: La scelta degli LLM per ogni livello si basa su metriche di prestazione e diversità delle risposte.

- Ruoli degli agenti: Gli LLM possono essere proponenti, che generano risposte utili, o aggregatori, che sintetizzano le risposte di altri modelli.

- Replica e riaggregazione: MoA introduce più aggregatori che perfezionano iterativamente le risposte, sfruttando i punti di forza di vari modelli.

Impatto Futuro di MoA e Collaborazione tra LLM

Lo studio su MoA evidenzia il potenziale di questa metodologia nel migliorare l’efficacia degli assistenti virtuali basati su LLM, rendendo l’intelligenza artificiale più accessibile e allineata con il ragionamento umano. La rappresentazione dei risultati intermedi in linguaggio naturale aumenta l’interpretabilità e facilita un migliore allineamento con le preferenze umane.

L’ottimizzazione dell’architettura MoA rappresenta una promettente area di ricerca futura, con la possibilità di migliorare ulteriormente le prestazioni. Tuttavia, l’aggregazione iterativa delle risposte nel modello MoA potrebbe comportare tempi di risposta iniziali elevati, influenzando l’esperienza utente. Per mitigare questo problema, si potrebbero limitare i livelli di MoA o esplorare l’aggregazione in blocchi.

In conclusione, l’approccio MoA apre nuove prospettive per la collaborazione tra modelli linguistici, migliorando la generazione del linguaggio e avvicinandoci a sistemi di intelligenza artificiale più efficaci e intelligenti.