Nel mezzo del fervore suscitato da ChatGPT e dall’intelligenza artificiale generativa (IA), c’è un crescente entusiasmo nel sfruttare il potenziale sempre più sofisticato di questa tecnologia. Tuttavia, secondo il sondaggio sull’IA in Nord America del 2022 condotto da Baker McKenzie, sembra che molti leader aziendali possano attualmente sottovalutare i rischi associati all’IA per le loro organizzazioni. In effetti, solo il 4% dei partecipanti di alto livello ha ritenuto “significativi” i rischi legati all’uso dell’IA, mentre meno della metà ha dichiarato di avere esperienza nell’ambito dell’IA all’interno del consiglio aziendale.

Questi risultati rivelano una situazione preoccupante: molte organizzazioni sono insufficientemente preparate per l’era dell’IA, mancando della supervisione e delle competenze necessarie da parte dei principali decision maker per affrontare in modo adeguato il rischio. Se non affrontate, le lacune organizzative nell’implementazione etica ed efficace di questa tecnologia potrebbero oscurare le opportunità di trasformazione, impedendo alle aziende di tenere il passo con la crescita esplosiva della tecnologia.

Come sta cambiando l’IA generativa il panorama del rischio?

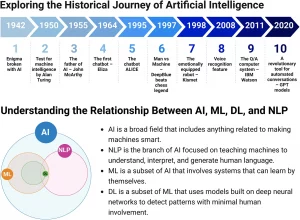

Attualmente, i progressi e l’adozione dell’IA stanno avvenendo a un ritmo esponenziale, talvolta considerato eccessivamente accelerato. Nonostante questa rapida crescita, professionisti del settore accademico, scienziati, policy maker e legali hanno a lungo promosso l’uso etico e legale dell’IA, in particolare in ambito lavorativo, dove le applicazioni esistenti dell’IA nelle risorse umane sono ampiamente diffuse.

Un sondaggio ha rilevato che il 75% delle aziende utilizza già strumenti e tecnologie di intelligenza artificiale per la selezione e la gestione delle risorse umane. In questa fase avanzata dell’IA generativa, i principi fondamentali di governance, responsabilità e trasparenza sono più cruciali che mai. Le preoccupazioni riguardanti le conseguenze di un’implementazione scarsa dell’IA sono rilevanti quanto mai.

Ad esempio, algoritmi non supervisionati possono portare a risultati distorti e discriminatori, aggravando le disuguaglianze e ostacolando la promozione di una forza lavoro diversificata. La protezione dei dati personali e le violazioni della privacy rappresentano un altro problema, spesso causato dalla mancata anonimizzazione e dalla raccolta indiscriminata di dati dei dipendenti.

Inoltre, l’IA generativa ha introdotto nuove considerazioni riguardo alla proprietà intellettuale, sollevando interrogativi sulla proprietà sia degli input che degli output dei programmi di terze parti e le successive preoccupazioni di violazione del copyright.

A livello normativo, stiamo assistendo a sforzi da parte di governi e autorità di regolamentazione per attuare leggi sull’IA e meccanismi di applicazione delle normative. Negli Stati Uniti, l’uso dell’IA nella selezione e nella gestione delle risorse umane sarà uno dei principali obiettivi delle normative emergenti. Anche le azioni legali, comprese le cause collettive, sono all’orizzonte. Già si stanno verificando i primi casi di contenzioso legati all’IA generativa sulla proprietà intellettuale negli Stati Uniti, e queste prime sentenze stanno contribuendo a definire il quadro giuridico in assenza di regolamentazioni consolidate.

Le organizzazioni che adottano l’IA generativa devono anche tenere presente che i dati inseriti negli strumenti e nelle query di intelligenza artificiale saranno spesso raccolti da fornitori terzi. In alcuni casi, questi fornitori possono avere il diritto di utilizzare e/o divulgare questi dati.

Nel contesto in cui i datori di lavoro stanno introducendo strumenti di intelligenza artificiale generativa per migliorare la loro forza lavoro, sorge la questione della vulnerabilità dei dati sensibili e delle informazioni commerciali riservate. In breve, sì, ogni passo nel processo decisionale, sia basato sull’IA o meno, porta con sé dei pregiudizi. Le aziende che adottano questi strumenti devono sviluppare un quadro che identifichi un approccio per valutare e mitigare i pregiudizi, garantendo nel contempo il rispetto delle normative sulla privacy dei dati.

Le organizzazioni che implementano l’IA devono anche mettere in atto processi che garantiscono una chiara comprensione dei set di dati utilizzati, della logica algoritmica e delle limitazioni tecnologiche. Questo diventerà sempre più rilevante poiché le future leggi sull’IA probabilmente richiederanno requisiti di reporting.

Quali sono le mosse giuste per le organizzazioni?

Per stare al passo con l’IA generazionale e per affrontare i rischi specifici dei diversi casi d’uso, le aziende dovranno superare gli sforzi isolati e creare un solido quadro di governance che riunisca tutte le funzioni coinvolte. Anche se molti si affidano agli scienziati dei dati per guidare le iniziative legate all’IA, è cruciale coinvolgere tutte le parti interessate, incluse le funzioni legali, i vertici aziendali, i consigli di amministrazione, la privacy, la conformità e le risorse umane, durante l’intero processo decisionale.

I risultati del nostro sondaggio hanno evidenziato la mancanza di rappresentanza in questo senso. Attualmente, solo il 54% degli intervistati coinvolge le risorse umane nel processo decisionale per quanto riguarda gli strumenti di intelligenza artificiale, e appena il 36% ha affermato di avere un Chief AI Officer (CAIO) in azienda.

In questo contesto ad alto rischio, il CAIO svolgerà un ruolo fondamentale nell’assicurare che ci sia una governance e una supervisione adeguate a livello di C-suite e che le risorse umane siano coinvolte nella formazione e nell’assistenza a un team interfunzionale di intelligenza artificiale.

In parallelo, le aziende dovrebbero sviluppare e implementare un solido quadro di governance interna che tenga in considerazione i rischi aziendali in tutti i casi d’uso, permettendo di apportare tempestivamente le correzioni di conformità necessarie quando i problemi emergono.

Il rischio per le aziende che mancano di una struttura di governance per l’IA e di una supervisione adeguata da parte delle parti interessate principali, o che si affidano ciecamente a strumenti di terze parti, è quello di utilizzare l’IA in modo tale da generare responsabilità legale (come ad esempio accuse di discriminazione).

In pratica, qualsiasi processo decisionale, basato su IA o su altri criteri, è intrinsecamente soggetto a pregiudizi. Le aziende che adottano queste tecnologie devono sviluppare un quadro che identifichi un approccio per valutare e ridurre i pregiudizi, oltre a garantire il rispetto delle normative sulla privacy dei dati. Gli sforzi per contrastare i pregiudizi dovrebbero essere accompagnati da efficaci misure di test prima e dopo l’implementazione.

Inoltre, le aziende che implementano l’IA dovrebbero stabilire processi che assicurino una chiara comprensione dei dati utilizzati, della logica degli algoritmi e delle limitazioni tecnologiche, poiché è probabile che le future leggi sull’IA richiederanno la rendicontazione di tali aspetti.

La lezione da trarre è semplice: l’IA sta venendo adottata su larga scala e in modo rapido, offrendo numerosi vantaggi. Tuttavia, la sua rapida implementazione richiede un’attenzione strategica e una governance rigorosa per garantirne un uso responsabile e la mitigazione dei rischi. Molte aziende non sono adeguatamente preparate per l’IA e tendono a sottovalutare i rischi, rischiando di adottare questa tecnologia senza le necessarie precauzioni.

Fortunatamente, stabilendo robuste strutture di governance e supervisione, le organizzazioni possono navigare attraverso le sfide tecnologiche, ovunque si trovino nel loro percorso nell’ambito dell’intelligenza artificiale.

In definitiva, la gestione a lungo termine dei rischi legati all’IA richiederà una collaborazione tra parti interessate, compresi professionisti legali, regolatori e specialisti della privacy, al fine di sviluppare leggi, codici etici o quadri guida che riconoscano sia le opportunità che i rischi presentati da questa tecnologia.

Con una solida struttura in atto, le organizzazioni saranno in grado di implementare l’IA in modo sicuro e sfruttarne i benefici con maggiore fiducia.