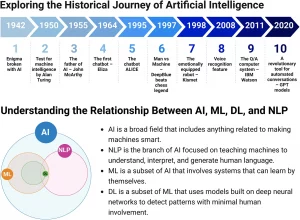

L’Intelligenza Artificiale (IA) ha permeato la nostra vita quotidiana in modi che potrebbero essere sembrati fantascientifici solo pochi decenni fa. Gli algoritmi di apprendimento automatico, una sottocategoria dell’IA, svolgono un ruolo essenziale in molti aspetti della nostra vita, dagli assistenti vocali sui nostri telefoni ai sofisticati sistemi di raccomandazione che guidano le nostre scelte di acquisto online. Tuttavia, con l’accelerazione vertiginosa dell’IA, emerge un crescente insieme di questioni etiche. Le due più urgenti tra queste sono il problema del pregiudizio nell’IA e la responsabilità delle decisioni prese dai sistemi IA.

Pregiudizio nell’Intelligenza Artificiale

Il pregiudizio nell’IA è un fenomeno che si verifica quando un algoritmo produce risultati sistematicamente favorevoli o contrari a certi gruppi di individui. Ciò può accadere quando i dati su cui viene addestrata l’IA riflettono i pregiudizi esistenti nella società.

Consideriamo un esempio concreto. Supponiamo che un’azienda decida di utilizzare un algoritmo di apprendimento automatico per migliorare il suo processo di assunzione. I dati storici dell’azienda mostrano che le posizioni di leadership sono state tradizionalmente occupate da uomini. Se l’algoritmo viene addestrato su questi dati, può “imparare” che i candidati maschi sono più adatti per ruoli di leadership. Di conseguenza, può sviluppare un pregiudizio di genere, favorendo i candidati maschi nelle sue raccomandazioni per le future assunzioni.

Questo non è un caso ipotetico. Nel 2018, Amazon ha scoperto che il suo algoritmo di assunzione aveva sviluppato un pregiudizio di genere, poiché era stato addestrato sui dati storici dell’azienda fortemente orientati verso i candidati maschi. Il risultato di questo pregiudizio ha avuto ripercussioni reali e significative: le donne sono state sistematicamente svantaggiate nel processo di assunzione.

Responsabilità per le Decisioni Automatizzate

Una seconda grande questione etica legata all’IA riguarda la responsabilità delle decisioni prese da un algoritmo. Chi dovrebbe essere ritenuto responsabile quando un sistema IA prende una decisione che causa danno? Questo è ancora in gran parte un territorio inesplorato, sia eticamente che legalmente.

Un esempio significativo riguarda le auto autonome. Supponiamo che un’auto autonoma causi un incidente con danni materiali o addirittura lesioni fisiche. Chi è responsabile in questo scenario? È il produttore dell’auto, per non aver costruito un sistema di guida autonoma sicuro? Sono responsabili gli sviluppatori del software di guida autonoma, per non aver adeguatamente previsto e gestito il caso che ha portato all’incidente? O è il proprietario dell’auto, per aver scelto di utilizzare la modalità di guida autonoma?

Conclusione

L’ascesa dell’IA ha portato con sé una miriade di benefici, tra cui maggiore efficienza, personalizzazione e comodità. Tuttavia, non possiamo ignorare le implicazioni etiche che derivano dall’uso sempre più diffuso dell’IA. Le questioni di pregiudizio e responsabilità sono particolarmente urgenti e richiedono la nostra attenzione.

In termini di soluzioni potenziali, potremmo considerare la creazione di linee guida chiare sulla responsabilità delle decisioni prese dall’IA, oltre a incoraggiare l’uso di tecniche di addestramento prive di pregiudizi. È anche importante educare il pubblico e gli sviluppatori di IA sull’importanza di queste questioni e le strategie per mitigarle. Questo potrebbe includere la promozione di pratiche etiche nella programmazione e nello sviluppo dell’IA, così come incoraggiare una maggiore diversità nel campo dell’IA.

Il compito davanti a noi non è solo creare un’IA più intelligente, ma anche creare un’IA che sia etica, equa e responsabile. Le implicazioni etiche dell’IA non sono un’aggiunta o un optional, ma una componente fondamentale del suo sviluppo responsabile.